什么是用户研究?

对于一个如此简单的术语,“用户研究”对于不同的人意义也是不同的。对于用户研究中的“用户”,Edward Tufte(Bisbort,1999)有一句名言:“只有两个行业把他们的顾客称作用户:计算机设计(译者注:computer design)以及贩毒。”

本书关注的是前者的用户。这里的用户可以是一个付费顾客、内部员工、物理学家、呼叫中心处理员、汽车司机、手机拥有者或是任何试图去完成某个目标的人——尤其是那些涉及到软件、网站以及机器设备的目标。

这里的“研究”宽泛而又模糊——它是以其为核心的方法和专业人员融汇的结果。Schumacher(2010,p.6)提出了以下的定义:

用户研究是对于用户目标、需求和能力的系统研究,它的目的是为了给设计、架构或改进工具来帮助用户更好的工作和生活。

相比起这个词语的定义以及它包含的内容,我们更关心如何量化用户的行为,因为这涉及到可用性相关专业人士、设计师、产品经理、营销人员以及开发者。

用户研究中的数据

尽管“用户研究”这个说法最终可能会失宠,但是它其中产出的数据却不会。贯穿本书,我们将把重点放在可用性测试,使用一些来自可用性测试、用户调查、A/B测试以及实景调研的案例。之所以把重点放在可用性测试上,是有以下三点原因:

- 可用性测试依然是判别用户是否在完成任务的核心方法。

- 作者均执行过大量的可用性测试并对其有着很多论述。

- 可用性测试用到了许多其他用研方法所涉及到的指标。(比如到处都能看到的“完成率”)。

可用性测试

可用性有一个国际标准:ISO 9241 pt.11(ISO,1998),其中把可用性定义为:在具体的使用场景下,一个产品能帮助具体用户有效果、有效率并满意地达到一个具体目标的程度。尽管没有方法来衡量效果、效率以及满意度,一项09年针对将近100个总结性可用性测试的大型调查(Sauro和Lewis,2009)发现了执行测试的人一般能收集到的内容。大部分的测试包含了一些组合,这些组合包括:完成率、错误、任务时间、任务级别满意度(译者注:task-level satisfaction)、测试级别满意度(译者注:test-level satisfaction)、帮助途径以及可用性问题列表(一般包含频率和程度)。

总体上来说,有两种可用性测试:找到并解决可用性问题(形成性测试)(译者注:formative tests)和用指标描述一个应用的可用性(总结性测试)(译者注:summative tests)。这里的“形成性测试”和“总结性测试”两个术语来自教育界(Scriven,1967)用于描述学生学习水平测试时用到的类似方式(“形成性”——提供即时的反馈来改进学习方式以及“总结性”——评估学到的内容)。

大多数的可用性测试属于总结性的。它们通常是一个小样本量的定性活动,在其中问题描述以及设计建议是以数据的形式输出的。你的目标是发现尽可能多的问题并找到解决方案,但是这并不意味着没有定量什么事。你可以从频率、程度的角度量化问题,追踪哪些用户碰到了哪些问题,衡量一下他们完成任务花费的时间,判断一下他们是否成功的完成了任务。

通常来讲有两种典型的总结性测试:基准测试以及比较测试。基准可用性测试的目标是描述一个应用相对于一系列基准来说的可用程度。在基准测试里你可以提出一个界面中需要修复的问题并且它也提供了用于比较设计后改变的一条基线。

比较可用性测试,就像他的名字一样,这可以是比较同一个产品的不同版本,也可以是比较几个竞品。在比较测试中,同一个用户可以在所有的产品上尝试完成任务(主题下的设计),或者不同组的用户可以试验各个产品(主题间的设计)。

样本量

对于样本量有一种错误的观点认为必须越大越好,这样才可以让数据精确可使用并量化成可用数据。我们将在第6.7章中深入探讨这个问题,并且在本书中,我们都将展现给你如何在样本量小于10的情况下获得有效的数据结果。不要让你的样本量(哪怕你只有2到5个用户)阻碍你使用统计信息来量化数据并指导最终的设计方案。

代表性和随机性

和样本量能够扯上些关系应该算是样本的构成。对于一个小样本经常会有人担心它不够有代表性。样本量以及代表性其实是不同的概念。你可以建立一个数量只有5但是能够代表人群的样本,你也可以建立一个样本量高达1000但是并没有什么代表性的样本。有关这两个不同概念最著名的例子之一便是1936年《文学文摘》(译者注:Literary Digesst)做的关于总统候选人民意调查。这本杂志调查自己的读者倾向于投票给哪位候选人并收到了240万份结果,但是最后却预测错了大选结果。这里面问题不在于样本的大小而在于样本的代表性。而《文学文摘》收到回复的人群大多是高收入高学历人群——显然并不能够代表所有人。(详见wiki)

在用户研究中,无论数据是定量的还是定性的,最重要的一件事在于你测试的用户样本能够代表你所要针对的所有人。否则你的调研结果从逻辑上就不适用于你的目标人群。如果你用一个群体的样本来推断另一个不同的群体,那么再好的统计学都帮不上忙。如果你想要深入了解如何改进雪地鞋的设计,去调研5个极地探险者都要比调研1000个冲浪者来的好。在实践中,这就意味着如果你试图从不同的用户群里得出结论(比如,新用户和经验用户,或年长用户和年轻用户),你就该让样本很好的代表不同的用户群。

关于样本量和代表性存在困扰的一个原因在于,你的人群,比如说是由10个不同的组构成,而你的样本量是5,那么显然样本量不够来代表所有的组别。你就需要针对这制定合适的取样方法来保证从每个需要调研的组别中都取得样本——这个方法又叫“分层取样”(译者注:Stratified Sampling)。比如说,如果你有理由相信以下几点,则考虑从不同组取样:

- 在关键指标上不同组别之间有潜在的重要差别。(Dickens,1987)

- 组与组之间存在潜在交流。(Aykin and Aykin,1991)

- 在关键指标的变动性上,组与组之间不同。

- 不同组之间取样成本不一样。

Gordon和Langmaid推荐用一下方法来定义一个组(1988):

- 写下所有重要的变量。

- 如果需要的话,按优先级对变量排序。

- 设计一个理想的样本。

- 利用常识来合并组。

举例来说,假设你一开始有24个组,这些组都是基于6个人口统计地点、2种经历、2种性别的组合。你可能规划着(1)每组中都包含同样数量的40岁以上和以下的男性女性,(2)初学用户和经验用户分开,然后(3)弃用中间的那些用户。最后的规划需要从2个组里取样。而没有合并性别和年龄的规划则需要从8个组里取样。

我们理想的假设你的样本是从母人群中随机挑选的。现实中这一点十分困难。除非你强迫用户去参与调查,否则多多少少不会完全随机。在可用性研究和调查中,如果人们决定参与,那么这一组里可以有不同的特点,而如果人们不选择参与则反之。这个问题不仅仅存在在用户研究中。即便在要对药物以及医疗程序作出生与死的决定的临床测试里,人们又不得不参与或者有某种疾病(癌症或糖尿病)的时候,也有这样的情况。许多心理学课本里关于人们行为的准则居然是被一些大学本科生得出的——这是一个潜在的代表性以及随机性问题。

你必须要意识到你的数据依旧是存在偏差的,这也将制约到你的结论。在应用研究中,我们被预算以及用户参与度所拘束,可是产品依然必须要产出。所以,在我们能收集到的数据的基础之上,我们尽量做出最正确的判断。在尽力让样本中的系统偏差最小化的同时要记住,代表性比随机性更加重要。换句话说,哪怕你有一个非常完美的随机样本,但是它选取自错误的人群,那么这个样本也比不上选取自正确人群但不完美的样本。

数据收集

可用性数据可以在一个传统基于实验室的有主持过程里被收集,这个过程中,用户去完成任务,而一个主持人将观察并与他们互动。这样的测试过程无疑耗时耗力,并且还需要具备用户和观察人两个角色(这也阻碍其进行一些跨国的测试)。这样的研究一般运用小样本的统计学过程,因为每一个样本的成本实在太高了。

近些年来,远程主持以及无主持的过程越来越受欢迎。在远程主持的过程中,用户在自己的电脑上尝试完成任务,而主持人通过屏幕共享软件来观察并记录用户的行为。而在无主持的远程测试过程中,用户尝试任务(通常是在网站上),而软件记录下点击,页面浏览以及时间。对于远程测试的办法,读者可参阅《Beyond the Usability Lab》(Albert et al.,2010),里面有深入的讨论。

根据我们的经验,尽管量化人类行为动机是十分困难的,这些行为的结果却是易于观察、衡量并利用的。以下就是在用户研究里,可用性测试内外能收集到的一些常见指标描述。我们会在本书里不断用到这些术语。

完成率

完成率,也被称为成功率,是可用性指标里最为基本的。(Nielsen,2001)。他们一般都记录成二进制的数据:1代表任务成功,0代表任务失败。你所报告的成功率就是将那些成功完成任务的用户数量除以所以尝试任务的用户数量。举例来说,如果10个用户里有8个成功完成了任务,那么成功率就是0.8,通常报告里写成80%。你也可以用用100%减去成功率而记录失败率为20%。

当然,也有办法来定义一种表示部分成功的指标,但是我们更加推崇这种简单的二进制衡量方式,因为它更加利于之后的统计分析。本书里提到的成功率都是指这种二进制的成功率。

二进制统计的另一个好处在于它在科学以及统计学文献里无处不在。本质上来说,任何事物的出现和未出现都可以记录成1或者0,然后可以汇总成一定的比率。这个可以是在一个软件上完成任务的用户数量,或是从疾病中恢复的病人数目,又或是湖里补上来的鱼的数量,以及购买一个产品的顾客数量等等等等,它们都适用于二进制比率。

可用性问题

如果用户在完成任务的时候遇到了问题,而这个问题又和界面有关系。那这就是一个用户界面问题(UI问题)。UI问题的汇总通常以列表的形式出现。这个列表包含了问题名称、描述以及一个用来反映问题出现频率和对用户影响的级别评分。

计算问题出现频率的常用方法是把所有参与者遇到的问题数量除以参与者的数量。而评估问题影响程度常用的办法(Rubin,1994;Dumas and Redish,1999)则是为这个影响的程度打分,其参考以下标准:

- 这个问题是否导致任务无法完成;

- 这个问题是否导致完成的延迟或让用户遇到阻碍;

- 这个问题对于整个任务表现影响相对比较小;

- 这个问题有待继续观察。

当你在处理数据时,如果这些数据是多类别的,且有着一定的层次顺序,那么就很有必要用某种方式合并一下这些数据。一种方法便是用某种算法作为依据。Rubin(1994)描述了一种将影响的四个级别(利用上面介绍到的4个级别,4表示最严重)和问题出现频率的四个级别(4:大于等于90%;3::51-89%;2:11-50%;1:小于等于10%)通过分数叠加合并的办法。举例来说,如果一个问题被监测到有80%的出现频率,但相对来说影响较小,那么它的级别评分就是5(频率3分加上影响2分)。通过这种方法,级别评分可以从最小2分到最大8分之间浮动。

还有一个类似的合并策略是将监测到的出现频率百分比乘上影响分(Lewis,2012)。得到的级别评分范围取决于每个影响级别被赋予的值。如果你把最严重的影响级别定义为10分,那么最高级得分就是1000(也可以在这个基础上除以10,这样得出的结果就在1到100的范围内,便于分析)。剩余三个影响级别的值取决于测试方的判断,但一个合理的组合一般是5,3和1分。利用这些值,一个出现频率为80%、有着较小影响的问题的级别得分是24(80乘以3除以10).

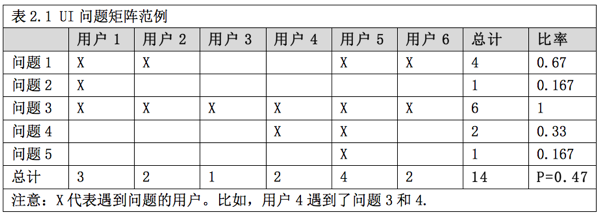

从分析的角度考虑,把UI问题和遇到问题的用户联系起来是组织这些问题的好办法,就像表2.1那样。

你要去了解在不同的测试阶段用户遇到一个问题的几率是多大。这能成为衡量可用性活动的影响以及ROI的关键指标。而了解哪个用户遇到哪个问题则能让你更好的估量你的样本量、问题发现率以及未发现问题的数量。(在第7章中会有详细讨论)。

任务时间

任务时间的意思是一个用户在一个活动中花了多久的时间。更详细的说,它就是用户成功完成一个事先定义好的任务场景所花的时间,但它也可以是在网页上呆的时间或电话时长。它可以用毫秒、秒、分钟、小时、天或年来衡量,并且通常都是以平均数的方式来写进报告(第三章有详细描述)。衡量并分析任务耗时有以下一些方法:

- 任务完成时间:成功完成任务的用户花费的时间。

- 任务失败时间:用户参与任务直到放弃或者错误的完成所花费的时间。

- 任务总时间:用户在任务上花费的所有时间。

错误

错误就是用户在试着完成任务的过程中任何意外的行为,小错、误解或遗漏。错误数目的统计可以从0(没有错误)到理论上无穷(虽然一般来说在可用性测试的一个任务里很少会出现超过20个的错误)。错误能够提供非常有用的诊断信息,这些信息有关用户为什么失败以及映射到UI问题里可能出现错误的地方。当然,错误也可以用二进制方式来衡量统计:用户或是遇到了错误(1=yes),或是没有(0=no)。

满意程度

在任务之后、可用性测试最后阶段或独立于可用性测试之外的时间里,可以提供有关系统易用性看法的问卷,完成这些问卷不会花费什么时间。虽然说你可以用自己编写的问题来评估对于易用性的感知,但如果你使用现有的标准化问卷,你的结论将会更加可靠(Sauro 和 Lewis,2009)。我们将在第八章里详细探讨标准化可用性测试问卷。

合并的分数

虽然可用性指标都互相紧密相关(Sauro 和 Lewis,2009),但是这个紧密的关系还不至于到它们相互能够替换对方。总的来说,那些完成了更多任务的用户更趋向于把任务评价的更简单并且完成的也更快。然后有些用户虽说没有成功完成任务,依然把任务评价的简单;或是有些完成任务很快的用户,却觉得任务比较困难。在可用性测试里手机多种指标数据是有益的,因为没有任何单一的数据能够像这一样真实的反映整体的用户体验。然而,分析报告这些数据将会是困难的,所以说如果将数据合并到一起,处理起来将会方便许多。一个合并的可用性指标和其他任何单一的指标一样,并且可以更好地用作执行面板(译者注:executive dashboards)的组成部分,或是用来判定产品之间的统计显著性(详见第五章)。如果你想了解更多关于合并多个指标为一个单一分数的内容,可以参阅Sauro and Kindlund(2005),Sauro and Lewis(2009),以及第九章中”Can You Combine Usability Metrics into Single Scores?”部分。

A/B测试

A/B测试,也叫做分半测试(译者注:split-half testing),是一种受欢迎的对比网页设计方案的方法。在这类由Amazon普及的测试里,用户随机的用两种开发好的设计备选方案进行操作。而两个方案设计上的区别可能像按钮上不同的文字或产品的不同图片一样微妙,也可能是采用了完全不同的页面布局和产品信息。

点击、页面浏览以及转化率

对于网站和网页应用来说,标准的行为便是自动记录其中的点击数和页面浏览量。而且在大部分情况下,如果你自己没有做研究的话,这些是你能获得的唯一数据。这俩个数据对于计算转化率、购买率或特色用法(译者注:feature usage)都很有帮助,并且在A/B测试中被广泛使用,尤其是像来分析完成率这样的工作。

为了检验到底哪个设计更好,你记录下每个设计参与的用户数量以及最后点击的用户数量。比如,如果有1000个用户参与了设计方案A,其中20个点击了“注册”;同时1050个用户在设计方案B中进行操作,48个用户点击了“注册”,那么转化率就分别是2%和4.5%。我们会在第五章里深入学习如何来判断设计方案之间是否有统计差异。

调研数据

调研是收集来自顾客相关态度看法的最简单方法。通常来说,调研包含了一些开放性的评价和是/否的回答,以及Likert式的评级量表数据。。

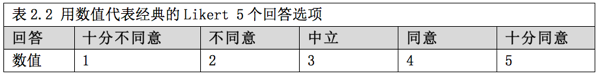

评级量表

评级量表里项目的特点是封闭式的回答选项。调查对象比较典型地会被要求对一个陈述发表同意还是不同意的看法(通常被称为Likert式项目)。为了方便数值分析,Likert经典的5选项回答能够被转化成1到5的数字(见表2.2)。

一旦你把这些回答的选择转化成了数字,你就可以计算出平均值和标准偏差,并生成可靠区间(见第三章),或是用这些回答来和不同的产品进行比较(见第五章)。第八章会细致的探讨具体到可用性层面的问卷以及评级量表。用这类数据可以计算平均值以以及进行标准统计测试,对此,人们有着一定的争议,第九章中“把来自不同陈述及不同级别的回答数据平均在一起是否合适?”这部分内容就会对此进行讨论。

净推荐值(译者注:Net Promoter Scores)

有关用户忠诚度以及未来购买行为的问题由来已久,许多公司在可用性测试中纷纷采用了一种最近出现的创新方法——净推荐问题以及得分(Reichheld,2003,2006)。著名的净推荐值(NPS)方法建立在一个有关顾客忠诚度的问题之上:有多大可能你会把这件产品推荐给你的朋友或者同事?回答的选项从0到10并分成以下三个维度:

- 推广者:9到10

- 被动者:7到8

- 批评者:0到6

把推广者回答的比重减去批评者回答的比重就得到了净推荐值。这个数值从-100%到100%的范围内浮动,数值越高意味着更高的忠诚度得分(推广者比批评者多)。虽然也有其他的评分评级方式可以分析有关方面(比如说平均值和标准偏差),但是净推荐值这样分段式的算分方式在统计处理上有着细微的区别(见第五章)。

注:Net Promoter(净推荐)、NPS(净推荐值)以及Net Promoter Score(净推荐值)系Satmetrix Systems,Inc., Bain&Company 和 Fred Reichheld的注册商标。

评价以及开放式数据

分析并为评价分级对于一个用研来说是最基本的任务。开放式的评价可能是各种形式的,例如:

- 顾客推广或批评一个产品的理由。

- 现场调查时用户的需求。

- 客服电话里对于产品的抱怨。

- 为何完成某个任务很困难。

就像可用性问题可以数量化一样,用户评价以及大部分开放式数据都可以被分类、量化并提交到统计分析中(Sauro,2011)。你可以进一步进行分析,并生成可靠区间,了解所有用户中有多大比重的人可能有这样的感觉(见第三章)。

需求的收集

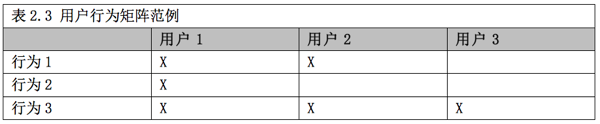

用户研究另外一个关键功能便是发现一个产品的特点以及功能。可能这和直接向用户询问他们要什么相比难多了,但是我们有许多办法来分析那些能够透露出未满足需求的用户行为。就像表2.3那样,这些行为可以在家里或办公地点被监测,然后像量化UI问题那样被量化。每一个行为将获得一个称呼和描述,然后你在下面的表格里记录下哪一个用户做出了某个特定的行为,就像表格里展示的那样。

你可以很方便的在报告里记录做出某个行为的用户比例,在这个比例附近生成可靠区间,就像在统计完成率时做的那样(见第三章)。你也可以把需求发现的统计学模型应用到预估样本量、需求发现率以及未发现需求数的工作中(见第七章)。

本章关键信息点

用户研究是一个宽泛的术语,它包含了能够生成量化结果的多种方法论,包括可用性测试、调研、问卷和现场调查等。

可用性测试是用户研究中最为中心的一种工作。通常生成例如完成率、任务时间、错误统计、满意度数据和用户界面问题这样的指标。

二进制完成率既是一种基本的可用性指标,也是科学研究的各个领域都能适用的指标。

你可以量化小样本里的数据并利用统计学来得出一定的结论。

即便是开放式的评论和描述也可以被分类并量化。

本文链接:http://www.mobileui.cn/quantitative-user-research.html本文摘自《Quantifying the User Experience》第二章,作者:JEFF SAURO和 JAMES R.LEWIS,由北京理工大学研究生侯松岩翻译。

本文标签: 可用性测试, 用户, 用户研究, 需求